人間にとって、「聞く」とはどういう意味をもっているのだろうか。それは本質的にことばによるコミュニケーションであるといってよいだろう。「聞く」ことは同時に、自分が「話す」ことにつながるからである。つまり、話すときには、自分の声を耳で聞きながら話している。いいかえればモニターしながら話しているわけで、もし自分の声を耳で聞いていなければ、うまく話すことはできない。このことからも、聞くことと話すこととは密接な関係にあることがわかる。人間以外の動物も危険を伝えたり、情動、怒りとか喜びとかを音声で表したりすることはあるが、人間のように、ことばというものをもたない。人間にとって、聞こえるということは、まず、「ことば」の問題を抜きにしては考えられない。したがって、単に聴覚を「聞く」だけの点で分離してとらえたり、話すことは音声であると割り切ったりすることには無理がある。

[角田忠信]

人間のことばの獲得は、最初は動物的な叫び声などからしだいに発達して、話しことばがつくられていったと推測される。そのことばのなかから歌声が生まれ、楽器もつくられ、さらに人間はいろいろな音の世界の広がりをもつに至った。視覚につながる文字の出現は、聞くことに比べれば歴史上ずっと新しいことで、聞くことのほうが、より根元的なのである。興味深いのは、どの高等動物の脳も左右二つに分かれているが、そのなかで人間だけが、ことばを獲得し、それを話すことによって、ことばの脳と、ことばでない脳との分化ができたことである。いいかえると、いろいろな音を聞くことのなかから、ことばの意味を知る脳と、そうでない脳とに、はっきり機能分化ができていることである。しかも話しことばの基礎が、乳幼児期という脳がもっとも柔軟な時期に、特別に意図的な教育をしないでも、自然の環境のなかで完成するのであるから、聴覚器官から入る刺激は、視覚とは違った、より生物学的な意義をもつものがあると考えられる(右脳・左脳については後で触れる)。

[角田忠信]

人間の耳は、周波数(音は空気の振動であり、1秒間の振動数を周波数といい、ヘルツという単位で表す)が20ヘルツ程度の非常に低い音から2万ヘルツ程度の高い音まで感じることができ、500~4000ヘルツの範囲の音を聞くのにもっとも適している。おもしろいことに、これは話しことばの音域にだいたい一致していることである。聴力がもっとも敏感なのは20歳代で、それを過ぎると、低い音を聞く能力はさほど変わらないが、高齢になるにしたがい、高音部に対する感受性が鈍くなる。

音は耳介から外耳道を通って鼓膜に達し、鼓膜を振動させる。この振動は中耳の3個の耳小骨に次々に伝わって、内耳のカタツムリに似た形の蝸牛(かぎゅう)とよばれる器官に伝達される。蝸牛は液体の充満した螺旋(らせん)管で、ここにコルチ器という聴覚器がある。耳小骨の振動によって蝸牛内の液体に波が生じ、この波がコルチ器内の神経細胞を興奮させ、神経衝撃(インパルス)に変換される。つまり中耳は、空気中の音波が効率よく液体振動に伝わるような変換器の役目を果たしている。インパルスは聴神経を伝わり延髄、脳幹を経て、大脳の左右側頭葉にある聴覚野(聞こえをつかさどる部分)に至り、ここで初めて音として認識される。

聴神経は大部分が脳幹のオリーブ核という部分で交叉(こうさ)しているので、運動神経や視神経と同じように対側支配が主である。つまり、右耳から入った音は左脳の聴覚野に行き、左耳から入った音はおもに右脳に行くが、一部の聴神経は同じ側に行くので、片方の耳に入った音も両側の聴覚野に伝わる。あとで述べるように、左脳は、ことばを支配する言語半球(この部分が冒されると失語症になる)とよばれる。しかしいままで述べた理由で、右耳で聞いたときだけことばがわかって、左耳で聞いたときにはことばがわからないということはない。

聴覚野に達した神経インパルスを意味のある音として認識するために、脳の何百万に及ぶ神経細胞網に蓄えられているあらゆる記憶、すなわち聴覚記憶だけでなく、視覚・味覚・嗅覚(きゅうかく)・触覚記憶などが動員され、情報の比較、対比、放棄といった処理を経て、脳は音の意味をつくりあげていくのである。

[角田忠信]

前述のように、左右の大脳の半球は言語半球と非言語半球とに分かれる。このような脳の機能の役割の分担を正常な人について調べるには、ダイコティック・リスニング法dichotic listening method(両耳分離聴取法)などが使われる。これは、聴覚について左右の脳の機能差を初めて実験的に研究したカナダのキムラ博士の方法で、両方の耳から同時に違ったことばを聞かせ、しかも両方のことばをできるだけ答えさせるということを行う。つまり違った情報を両耳に与え、両耳を競争状態にしておき、どちらの耳のほうが、より有効に判断できるかを検査するわけである。

この方法を行うと、対側支配という原則に従って、ことばの中枢のある左側と機能的に対応する反対側の右の耳から与えたことばのほうが、聞きやすいという結果が出る。片耳ずつ聞かせた場合にはまったく差は出ないが、両耳同時に刺激を与えて競争状態にすると、差が出てくる。これでことばの認知の仕方を調べると、正常な人では右の耳のほうが成績がよい。つまり、右耳に対応する左脳に言語半球があることがわかる。ところが、ことばでない音、たとえば器楽曲あるいはオーケストラのメロディを使って調べると、ことばとは逆に左耳のほうが成績がよい。このように、われわれのもつ左右二つの脳は、聞くということについてみた場合、ことばに向く脳と音楽に向く脳とに分けられる。こういう分け方は、いまのところ人種を超えて大きな矛盾はなく認められている。簡単に分ければ、左脳を「言語脳」、右脳を「音楽脳」とよぶことができる。

[角田忠信]

聴覚を使って脳を研究するという新しい方法で調査すると、各種の音に対する左脳、右脳の対応が、日本人と非日本人とでは明らかに違っていることがわかった。この事実は、遅延聴覚フィードバック(DAF)効果を利用した電鍵打叩(でんけんだこう)法(角田(つのだ)法)で確かめられたものである。

検査を受ける人に、一定のパターンで、たとえば4~2(・・・・ ・・)あるいは3~3(・・・ ・・・ ・・・)というパターンで連続して電鍵をたたかせる。そしてこの打叩を引き金として発生した50~75ミリ秒の短音を片耳で聞かせ、これに注意を集中させる。この状態は、人間がしゃべるとき、口から出た声を自分の耳で聞きモニターしているのに近いモデルで、口の動きを、電鍵をたたくという、指先の細かなパターン運動に置き換えたことになる。このような状態を続けている途中で、反対の耳から、音の性質は変わらないが、電鍵打叩を妨げるような遅延音(打叩と同時発生する音より0.15秒~0.4秒遅れて聞こえる音)を聞かせる。そうすると、この遅延音が小さいうちはじゃまにならないが、音を大きくしていくと、これが妨害音になって、しだいに打叩がしにくくなり、あるところにくると、正確な打叩ができなくなって、パターンを間違えたり、間隔が開いて乱れたりする。これは、自分の声を自分の耳で聞いてモニターしている場合に、モニターのほうを0.2秒ほど遅らせると、非常に話しづらくなり、どもってしまう状態とよく似ている。この電鍵打叩法では、同じ音による検査を両方の耳について行い、どちらの耳が妨害音に対して敏感であるかによって、検査に用いた音に対する優位半球(耳)が決定される。

[角田忠信]

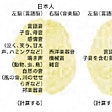

言語音(「あー」と長く延ばして発声した母音、三つずつにくぎった一定パターンの繰り返し子音「ta-ta-ta, ta-ta-ta」)、1010ヘルツの純音(単一の周波数からなる音)、ホワイト・ノイズ(数十ヘルツから10キロヘルツ以上の周波数の成分が平等に入っている雑音で機械音の代表)、西洋の音楽、一定パターンの繰り返しの多い邦楽器音、ハミングのメロディ、コオロギの鳴き声などを用いて検査した結果、左脳(言語脳)のほうで処理されている音は、母音、子音、囁語(じご)(声帯を振動しないようにしてささやいたような音)などの言語音、ことば、感情音、ハミング、自然の音、虫・動物の鳴き声、邦楽器音などである。

右脳(音楽脳)で処理されている音は、あらゆる周波数の純音、ホワイト・ノイズ、整然とした構成音、すなわちブザー音や矩形波、振幅の変わるAM音、西洋楽器音、オーケストラの音などである。この結果、優位性のパターンから脳を分類すると、ハーモニックな脳(右脳)、ハーモニックでない脳(左脳)とに、はっきり分かれる。

[角田忠信]

日本人は、いわゆる社会音とよばれている、ネコ・小鳥・カエル・イヌ・ウシ・ニワトリなどの動物の鳴き声、コオロギ・スズムシなど虫の鳴き声、それに、ことばではないが感情的な、泣き声、笑い声、うめき声、嘆き声、ハミング、また雨・風・波の音や小川のせせらぎなど、自然の音を左脳(言語脳)で処理している。同様に琵琶(びわ)・三味線・尺八・箏(こと)など邦楽器の音も左脳で処理される。日本人が右脳(音楽脳)で処理しているのは西洋楽器音、機械音、雑音だけで、他の音はだいたい左脳に入る。聞くことの優位性からみると、日本人は非常に左脳に偏っており、日本人以外は逆に右脳(音楽脳)に偏っているということができるだろう。この事実は、各種の音に対する左右の脳波の反応の仕方によっても確かめられている。

日本人は、母音のきわめて優勢な日本語を母国語としているため、母音の特徴であるハーモニックでない組合せ音からできている音や、組合せ音のなかで細かいFM音を含む音はすべて左脳優位に振り分けている。人の感情音をはじめ、虫の鳴き声、動物の鳴き声、自然の音などは先述のような特徴をもつ音であるから、自動的に左脳優位になると考えられる。日本語の基礎ができあがる9歳ころまでには、さまざまな感情体験と左脳による感情音の処理とが結び付くことによって、日本人に特徴的な言語脳優位の働きが形づくられていくものと考えられる。これがまた、日本人の情動のメカニズムも、それに基づいていると解釈でき、日本特有の文化をつくりあげる大きな要素となっているとみることができる。

日本語では、アイウエオの五つの母音が子音と同じように拍を形づくっており、言語情報の識別に、母音は西欧語以上に重要な役割を果たしている。母音だけからつくられているか、あるいは母音主体の意味のあることばが豊富な点(たとえば、うえ、おい、おおい、おいしい、おおきいなど)、また母音―子音―母音の組合せからできた重要な単語が非常に多いということなども、日本語の重要な要素である(たとえば、足、秋、姉、赤、雨、行くなど)。それは、西欧語のように、子音―母音―子音という子音主体の音節が主体となっているのとは、非常に対照的である。

そのような日本人と日本人以外の、聞くことの脳での処理の仕方の違いは、なぜおこるのだろうか。簡単にいえば、言語の処理をする脳のメカニズムが、話す言語にいちばん適したような処理をするからだと考えられる。

[角田忠信]

人間の聴覚と音声による普通のコミュニケーションに必要な最低の周波数は、声帯の振動数の下限にあたる100ヘルツ付近である。それ以下の99ヘルツより低い音は、話しことばのコミュニケーションには不必要な部分と考えられている。しかし最近、この99ヘルツ以下の低域純音が、100ヘルツ以上の純音とは基本的に異なった、生理的意味をもつのではないかという研究結果が得られている。この99ヘルツ以下の低音域はことばとは関係がないだけに、すべての人類に共通な、さらに広く他の哺乳(ほにゅう)動物にも共通して受け取られているようである。これを100ヘルツ以上の音声言語領域と対比して「生物学的領域」とよんでいるが、この領域の生理的意味は現在まだ明らかではない。しかし実験を連日続けると被検者は、99ヘルツ以下の音を不快に感じ、自律神経が刺激を受けたときに現れる症状を訴えることがある。そこから、99ヘルツ以下の低域純音は、自律神経系との関係が深いと考えられる。この点については今後の研究に待つほかはないが、そこには、人間を含めた生物にとって、なにか重要な秘密が隠されているのではないだろうか。

[角田忠信]

人を取り巻く環境は、質および量において無限に多様で、広範な刺激エネルギーをもつが、人はそのうちのきわめて限られた範囲を情報として摂取し、選択的に反応する。「きく」の問題を、人の行動の選択的反応という面から考察してみよう。

生体は視覚、聴覚、触覚、味覚、嗅覚(きゅうかく)、自己受容感覚などの感覚器官、感覚経路によって、環境および自己の身体からの情報を摂取するが、聴覚による情報の摂取を「きく」という。パーティーなどで、多くの人が三々五々に分かれて談笑しているとき、多くの声が耳に入っても、話し相手の声だけが聞こえ、他の声が話し相手の声より大きくても、それが聞こえないことがある。また、オーケストラの特定の楽器、奏者の音だけを聴くこともできる。この現象を「カクテル・パーティー効果」という。人は、音のくる方向、音質、アクセント、相手の口唇の動きやしぐさ、ことばの推移確率(文法、話題や文脈によって変化する語の続き方)など多くの手掛りを駆使して、音や声、相手の話を聴く。「きこえる」は「受動的反応」であるが、「きく」は積極的な「選択的反応」である。

2個のイヤホンの1個を一方の耳に、他のイヤホンを他の耳に入れ、それぞれの耳に別の音を流し、一方の音だけを聴き取らせる両耳分離聴取法(ダイコティック・リスニング法)などによって、カクテル・パーティー効果についての多くの研究が進められてきた。『日本書紀』によれば、聖徳太子は同時に10人の話を聴き取ったというが、人は一度に限られた情報しか処理できない。この処理限界があるために、フィルターが1種類の情報だけを通し、他の情報をカットするという単一回路説もあるが、このような考え方では、話し相手以外の声でも、自分や恋人の名前あるいは自我関与の高いことが、突然、聞こえてくるという現象を説明できない。現在においては、多くの情報が同時に、並列的に、ある程度まで処理され、そのうち関与度の高い情報だけが選択され、摂取されると考えられている。人の耳はしょせん「勝手耳」といえるかもしれない。「きく」と「話す」とは相互に、密接に関連する。聴覚に障害があれば、発声、調音(構言)機構に障害がなくても(声帯の振動によって声帯原音voiceをつくる機制を発声といい、声帯から口唇までの声道によって、特定の音響的特性をもつ言語音声speech soundをつくる機制を調音articulationという)、言語障害が生じることはよく知られているが、これとは逆に、調音できない音声は聴き取ることができない。たとえば、日本人にとって一般に /l/ と /r/ を聴き分けることは困難であるが、調音し分けられるようになると聴き分けられるようになる。意味の差異を生じる音声の最小単位を音素phonemeというが、人はそれぞれ自分の音素体系の枠組みにより、音声を聴き、調音しているのである。「きく」は耳だけの問題ではない。

[牧野達郎]

『角田忠信著『日本人の脳』(1978・大修館書店)』▽『角田忠信著『右脳と左脳』(1981・小学館創造選書)』▽『ナイサー著、古崎敬・村瀬旻訳『認知の構図』(1978・サイエンス社)』